El resumen es, a menudo, la única parte de un artículo que muchos lectores llegan a consultar. Es la primera puerta de entrada para investigadores, clínicos, revisores y facilita la comprensión rápida de los objetivos, métodos y resultados principales de un estudio. Pero además cumple un papel esencial en la recuperación de información: en bases de datos y motores de búsqueda -especialmente si no disponen de tesauro- las búsquedas se realizan fundamentalmente en los campos de título y resumen, y no en el texto completo de los artículos. Esto significa que, si los conceptos clave del estudio no están descritos de forma clara y completa en el resumen, es probable que el artículo no sea recuperado en una búsqueda bibliográfica, aunque sea muy relevante para la pregunta de investigación.

La calidad del resumen no solo es importante para que los lectores comprendan el estudio, sino también para que el artículo sea recuperable y visible en las búsquedas bibliográficas.

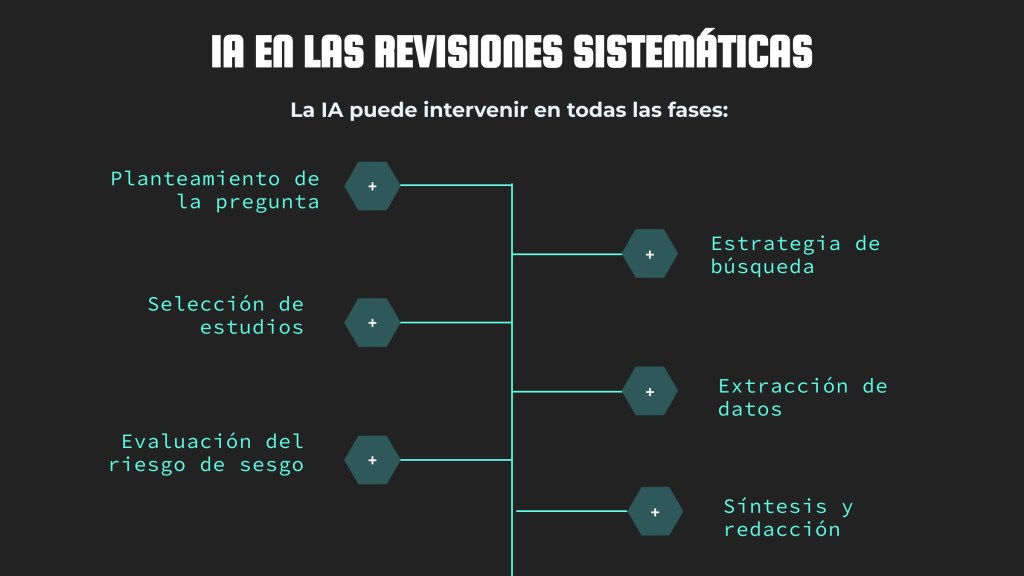

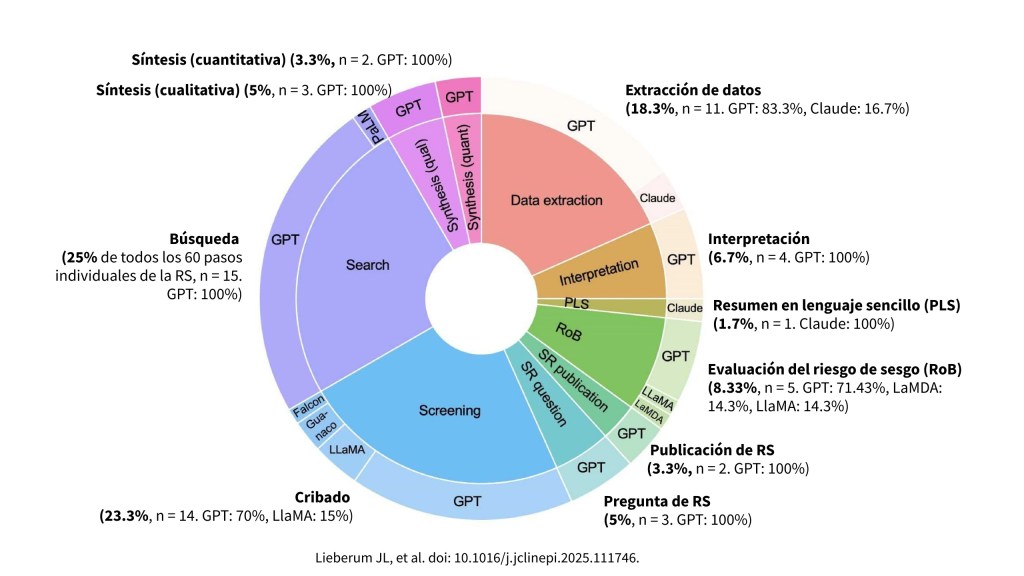

En un contexto donde cada vez se publican más artículos, los resúmenes no solo son leídos por personas, sino también procesados por herramientas automáticas de cribado y algoritmos de inteligencia artificial que ayudan en la selección de estudios para revisiones sistemáticas.

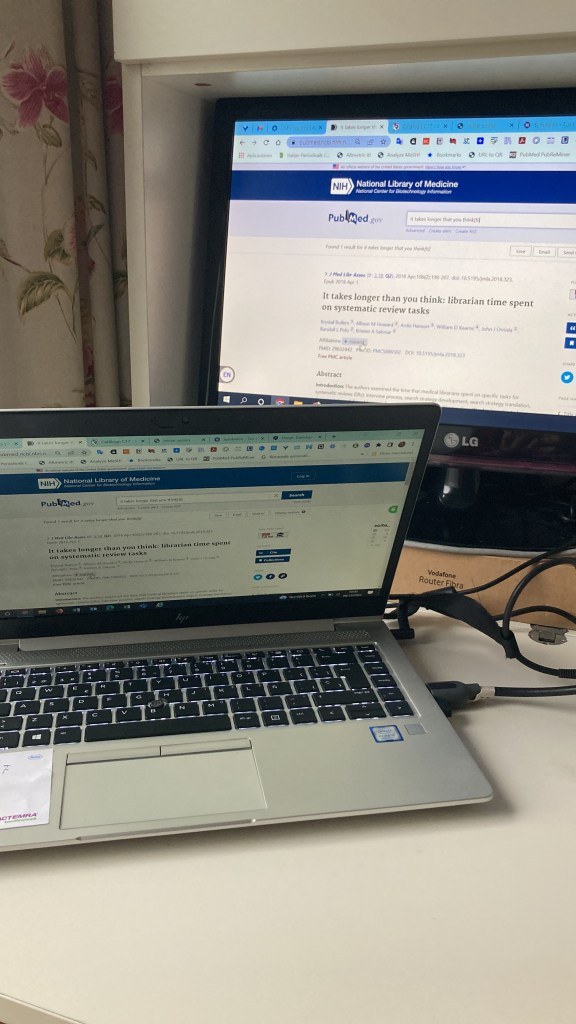

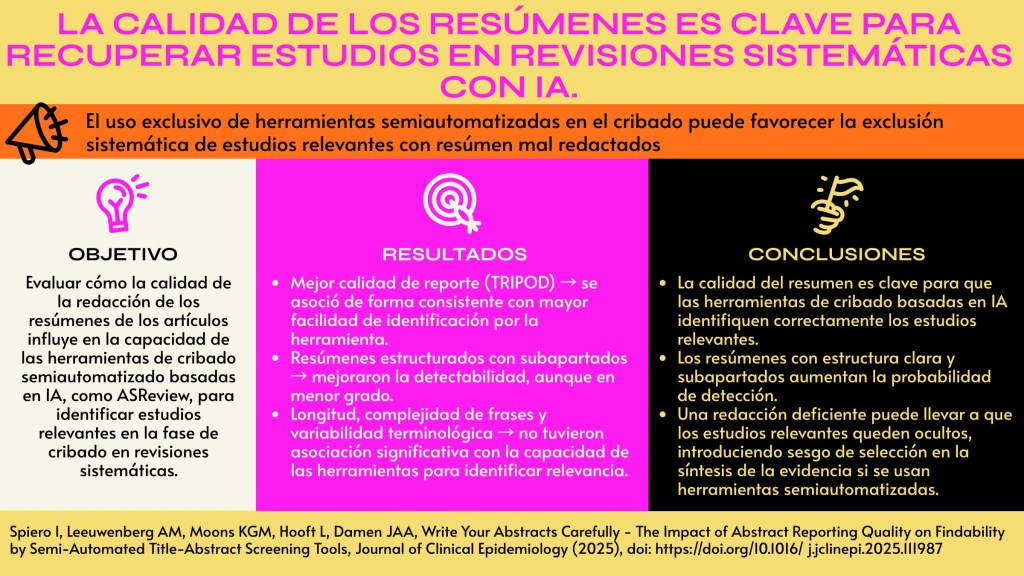

Un artículo reciente publicado en el Journal of Clinical Epidemiology (Write Your Abstracts Carefully – The Impact of Abstract Reporting Quality on Findability by Semi-Automated Title-Abstract Screening Tools, Spiero et al., 2025) demuestra con claridad esta idea:

- Resúmenes de mayor calidad (medidos con los criterios TRIPOD) son más fáciles de identificar como relevantes por herramientas de cribado semiautomatizado.

- El uso de subapartados en resúmenes estructurados también aumenta la probabilidad de que los artículos sean detectados.

- En cambio, aspectos como la longitud del resumen o la variación terminológica no influyen en la capacidad de las herramientas para identificar artículos relevantes.

¿Por qué es importante esto?

Porque si los resúmenes están mal redactados, los estudios relevantes pueden pasar desapercibidos, lo que introduce sesgo de selección en las revisiones sistemáticas, y debilita la calidad de la síntesis de la evidencia.

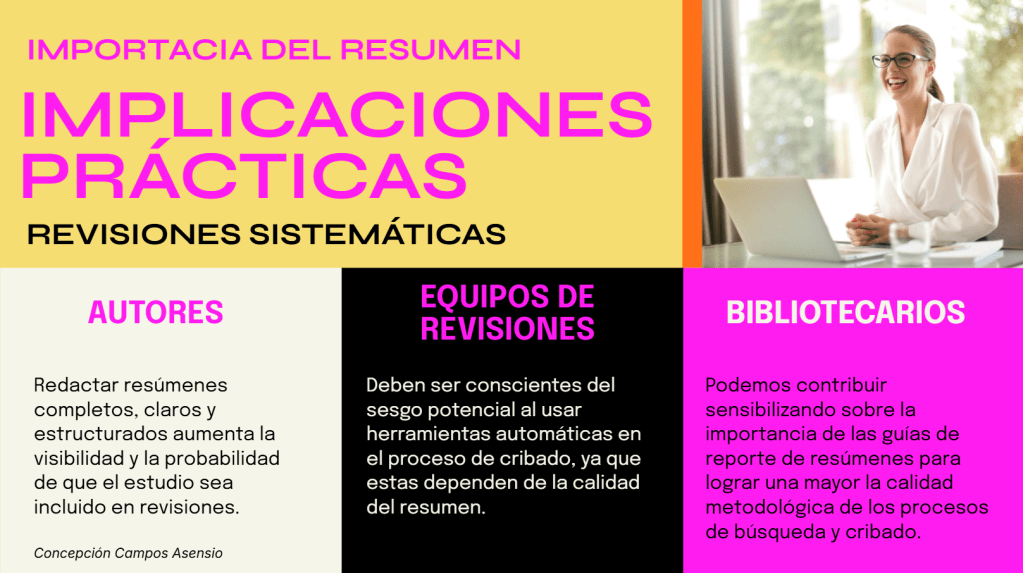

Implicaciones prácticas

Para los autores de los artículos:

- Redactar resúmenes completos, claros y estructurados, siguiendo las guías de reporte, aumenta la visibilidad de sus estudios en revisiones sistemáticas.

- Una mala calidad de resumen puede traducirse en menor probabilidad de ser incluido en síntesis de evidencia, incluso si el estudio es relevante.

Para los equipos de revisiones sistemáticas:

- Deben ser conscientes de que los algoritmos de cribado dependen de la calidad del resumen: resúmenes pobres pueden ser omitidos por las herramientas.

- Es recomendable mantener estrategias de búsqueda amplias y sensibles, y vigilar el posible sesgo por omisión de estudios relevantes con resúmenes deficientes.

- Documentar esta limitación metodológica en los protocolos y discusiones de las revisiones.

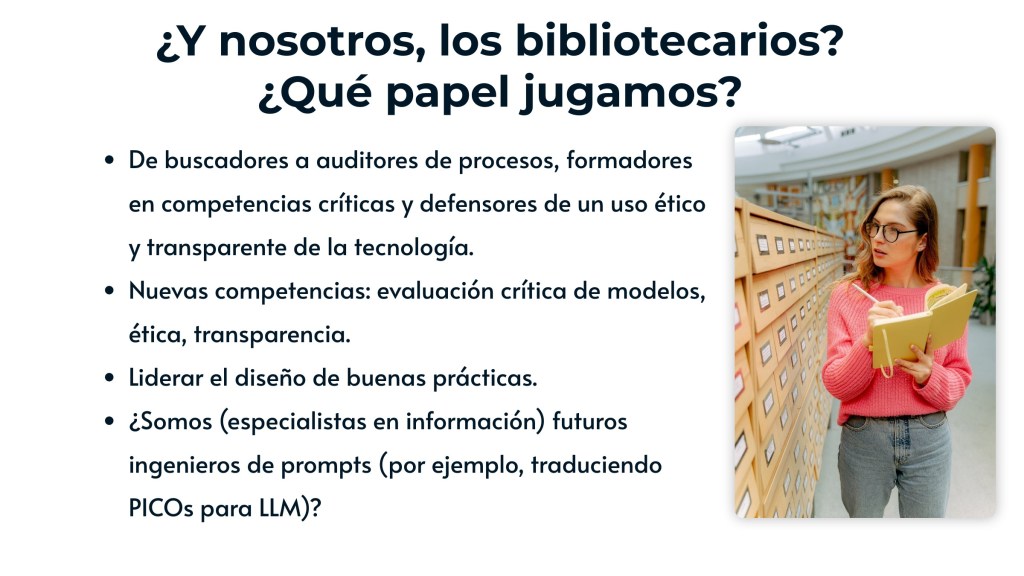

Para los bibliotecarios:

- Al apoyar en búsquedas y cribado, conviene alertar sobre el riesgo de sesgo asociado a resúmenes mal redactados.

- Los bibliotecarios pueden desempeñar un papel formativo, promoviendo la adhesión a guías de reporte (CONSORT, STROBE, TRIPOD…) entre investigadores y clínicos.

- En la práctica, esto refuerza el papel del bibliotecario como garante de la calidad metodológica y transparencia en la síntesis de la evidencia.

En definitiva, escribir un buen resumen no es solo un ejercicio de comunicación científica: es una garantía de visibilidad, accesibilidad y rigor científico.

Referencia

Spiero I, Leeuwenberg AM, Moons KGM, Hooft L, Damen JAA, Write Your Abstracts Carefully – The Impact of Abstract Reporting Quality on Findability by Semi-Automated Title-Abstract Screening Tools. J Clin Epidemiol. 2025, doi: https://doi.org/10.1016/j.jclinepi.2025.111987.