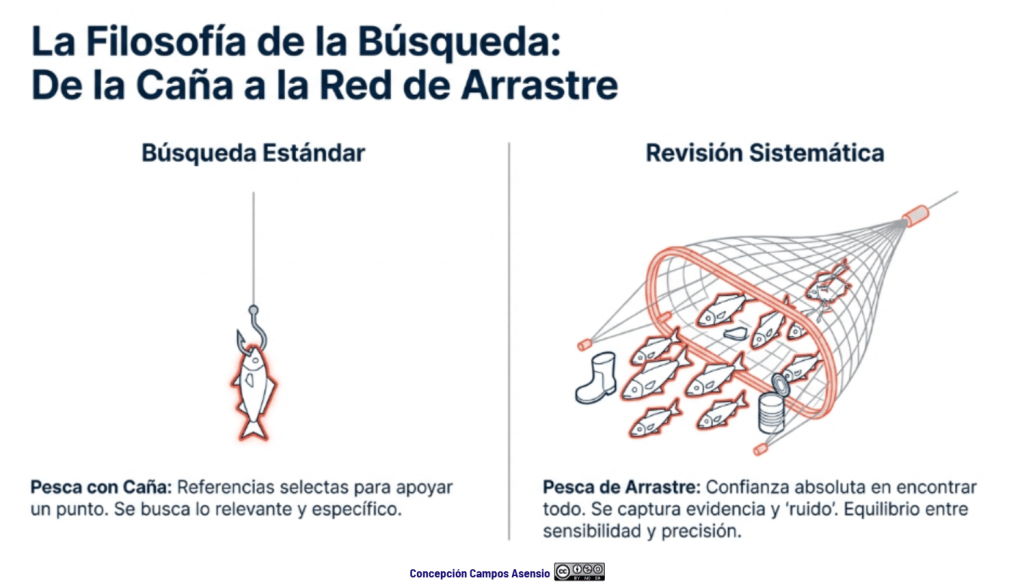

Los estándares metodológicos coinciden en una idea central: la búsqueda debe ser sistemática, planificada y lo más amplia posible para reducir sesgos (especialmente sesgo de publicación y de reporte) y capturar la mayor parte de la evidencia relevante (1). A diferencia de una revisión tradicional donde un autor puede elegir artículos de su preferencia («handpicking»), una búsqueda exhaustiva busca identificar toda la evidencia disponible que responda a una pregunta de investigación específica para evitar el sesgo de selección. En una anterior entrada ya hemos analizado cómo podemos saber si nuestra búsqueda es exhaustiva. Ahora veamos lo que realmente significa “exhaustividad” (comprehensiveness).

Exhaustividad no equivale a “hacer una búsqueda larga” ni a “meter muchas palabras”. Es diseñar un proceso que aspire a identificar el conjunto más completo y no sesgado posible de estudios pertinentes para una pregunta predefinida. En el Manual Cochrane (1) lo expresa de forma directa: la búsqueda debe ser tan extensa como sea posible para reducir el riesgo de sesgo de reporte/publicación e identificar la mayor cantidad de evidencia relevante.

¿Significa esto que hay que usar absolutamente todos los métodos imaginables?, no, es decidir (y justificar) cómo lograr un conjunto de evidencia completo y no sesgado con los recursos disponibles.

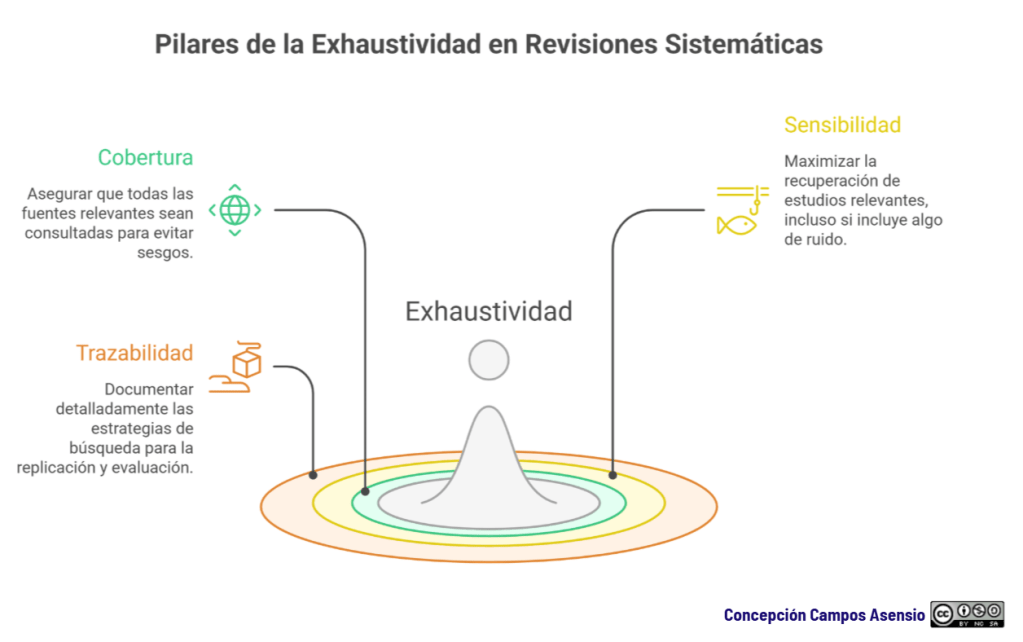

3 pilares de la exhaustividad: cobertura, sensibilidad y trazabilidad

Si una búsqueda no es exhaustiva y documentada en detalle, la evidencia resultante no se considera válida ni fiable para la toma de decisiones clínicas. Es, de hecho, el factor principal que distingue a una revisión sistemática de cualquier otro tipo de revisión bibliográfica.

Analicemos los tres pilares de la exhaustividad:

1. Cobertura: no hay exhaustividad con una sola fuente

Una revisión que busca “toda la evidencia” pero consulta una única base (p. ej., solo PubMed) es vulnerable por definición: indexación incompleta, diferencias en tesauros, retrasos de indización, sesgos geográficos/idiomáticos, etc. La evidencia empírica lo respalda: en un estudio sobre revisiones Cochrane, buscar en ≥2 bases de datos aumentó cobertura/recall y redujo el riesgo de perder estudios elegibles; y cuando se sospecha que los artículos son difíciles de localizar, deben añadirse métodos suplementarios (2).

Y, desde la perspectiva de combinaciones “óptimas”, Bramer et al. observaron que varias referencias incluidas solo aparecen en una base de datos y propusieron como combinación mínima eficiente (dependiente del tema) incluir, al menos, Embase, MEDLINE, Web of Science y Google Scholar para maximizar recall (3).

Bien es verdad que no existe un número universal de bases de datos. Lo que exigen los estándares es justificar por qué esas fuentes son las adecuadas para tu pregunta y tu campo. Cochrane (1), por ejemplo, establece como mínimo para sus revisiones la consulta de CENTRAL, MEDLINE y Embase, además de fuentes especializadas según el tema.

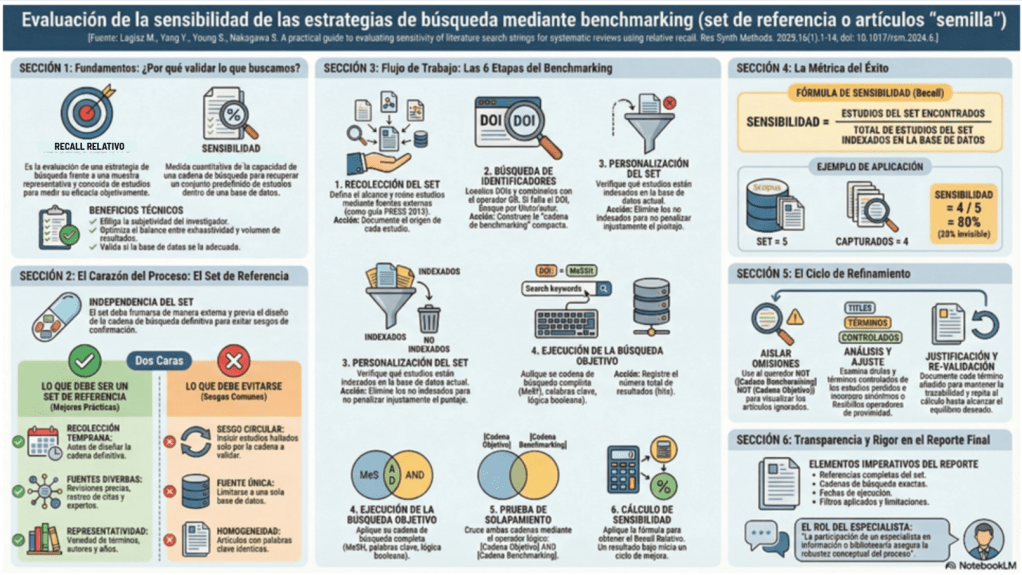

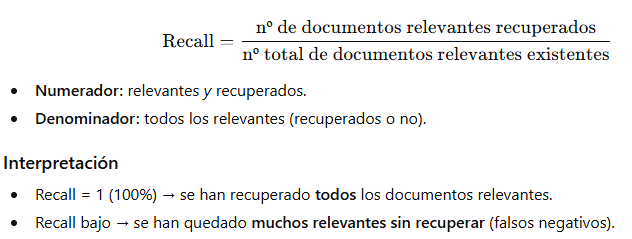

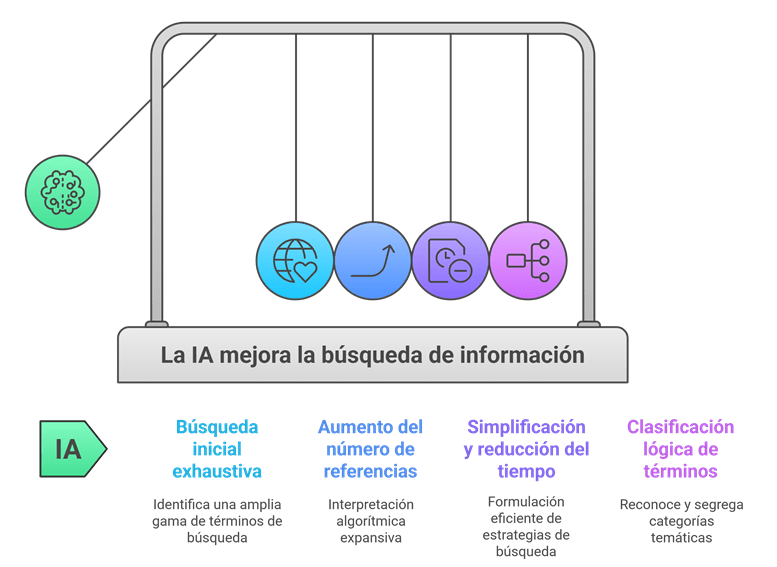

2. Sensibilidad: maximizar recall sin perder el control

La búsqueda exhaustiva prioriza sensibilidad (recall) frente a precisión (precision), aceptando que habrá ruido. El Manual Cochrane (1) lo formula explícitamente: hay que maximizar sensibilidad procurando una precisión razonable; aumentar sensibilidad suele bajar precisión y recuperar más irrelevantes. En este punto hay que afirmar que ruido no significa mala búsqueda; puede significar que se ha protegido la revisión contra la omisión de estudios relevantes.

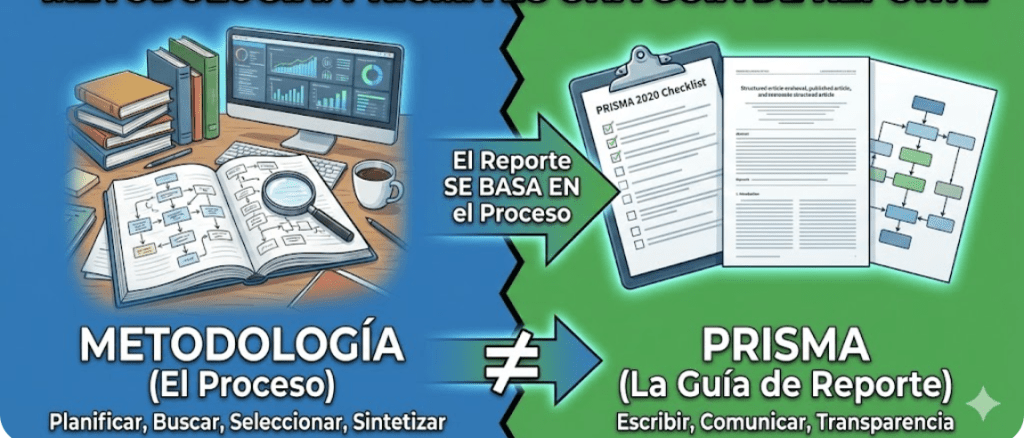

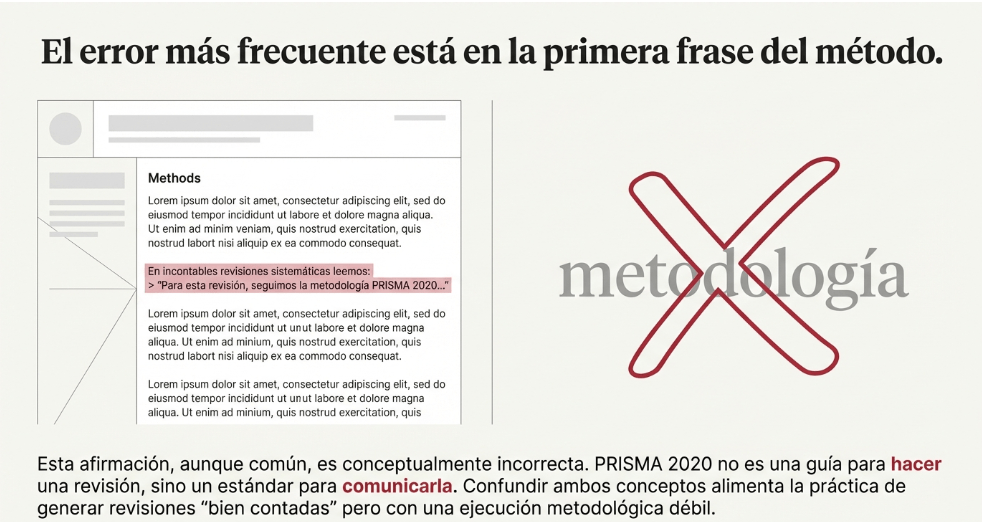

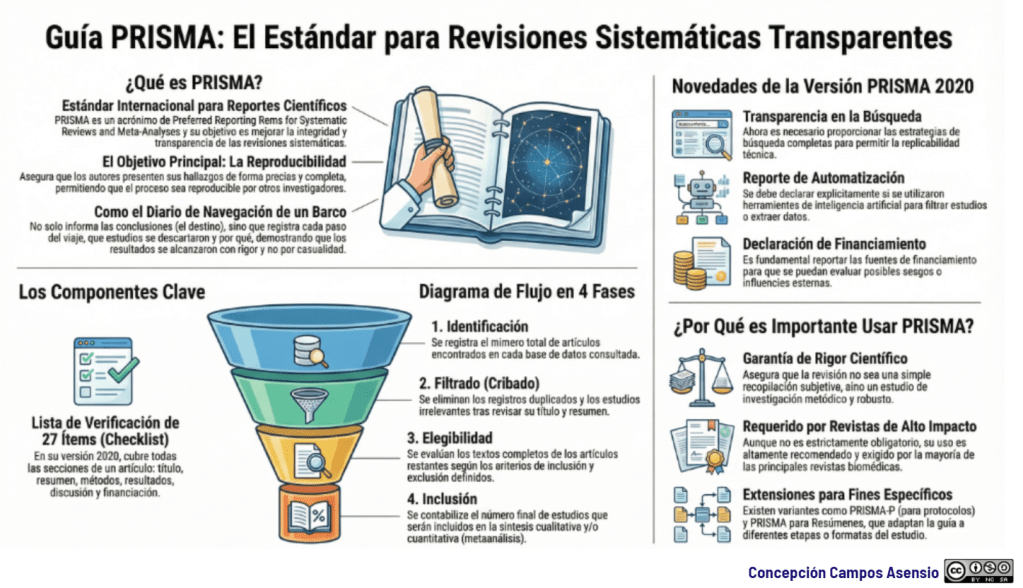

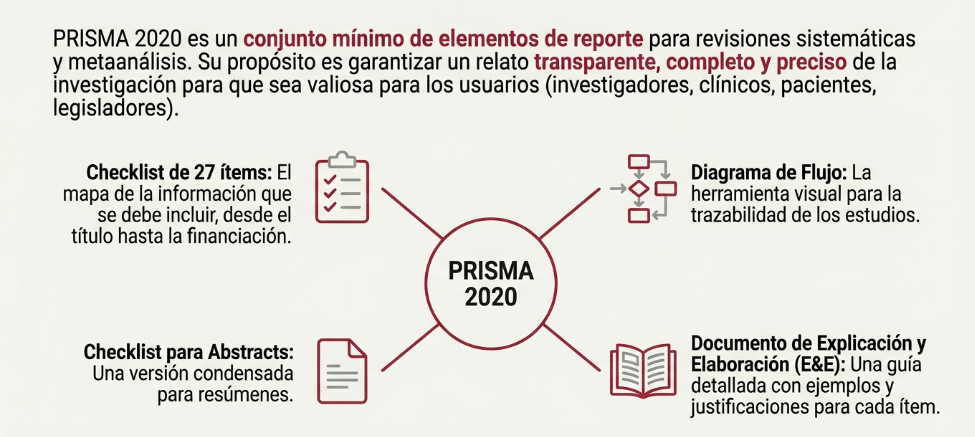

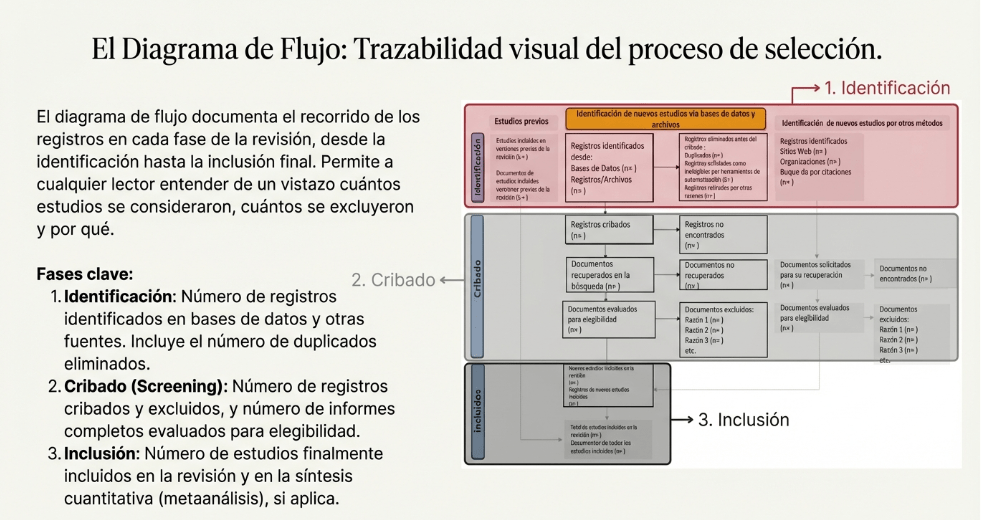

3. Trazabilidad: exhaustividad sin documentación no existe

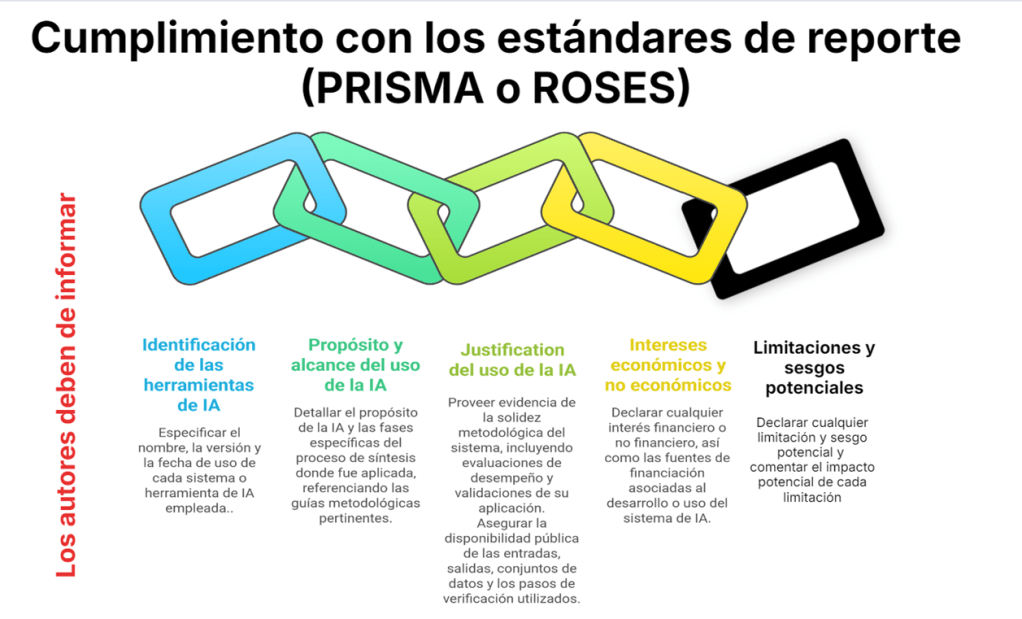

Una búsqueda “muy buena” pero no reproducible es metodológicamente débil. PRISMA 2020 (4) exige describir todas las fuentes consultadas (bases, registros, webs, listas de referencias, etc.) y la fecha de última consulta. Además, pide presentar las estrategias completas (línea a línea) para todas las bases/registros/webs, con límites y filtros, para permitir evaluación de la exhaustividad, replicación y actualización.

PRISMA-S (2021) va un paso más allá con una lista específica (16 ítems) para reportar búsquedas de forma completa y reproducible (5).

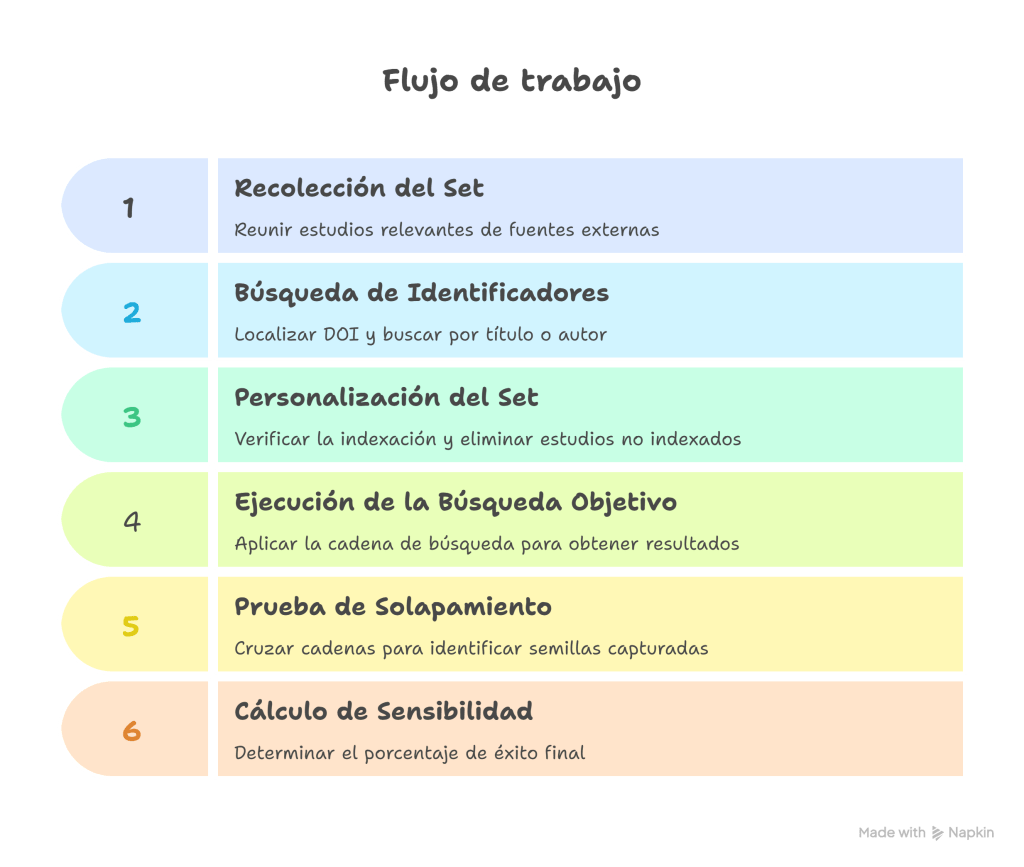

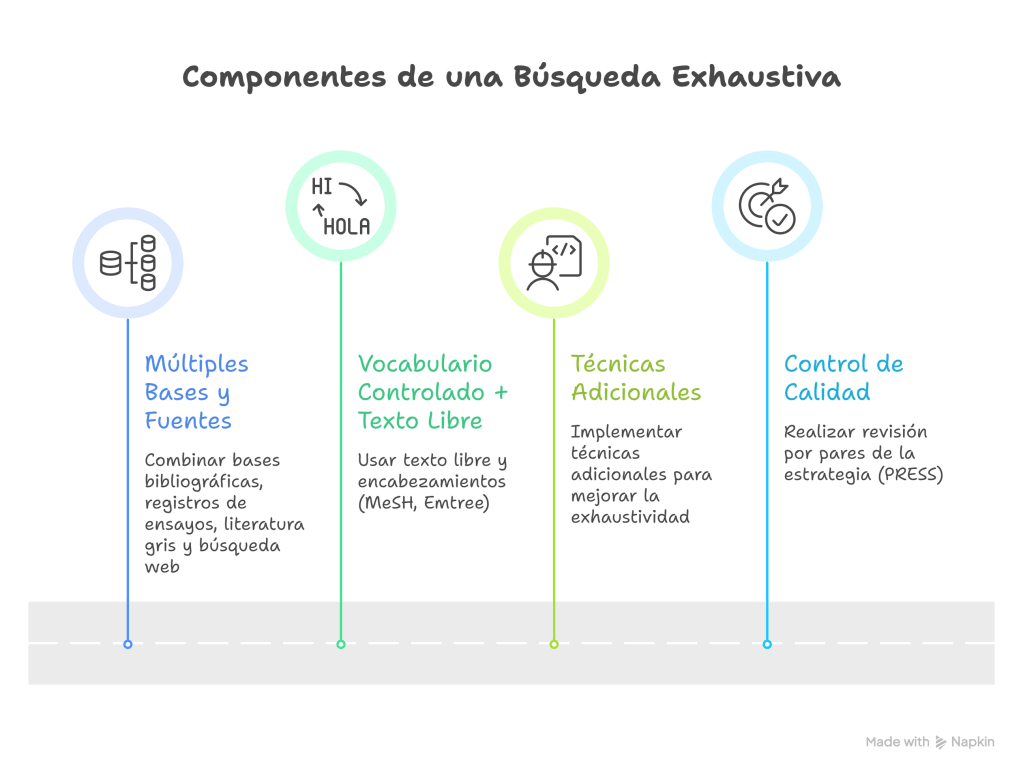

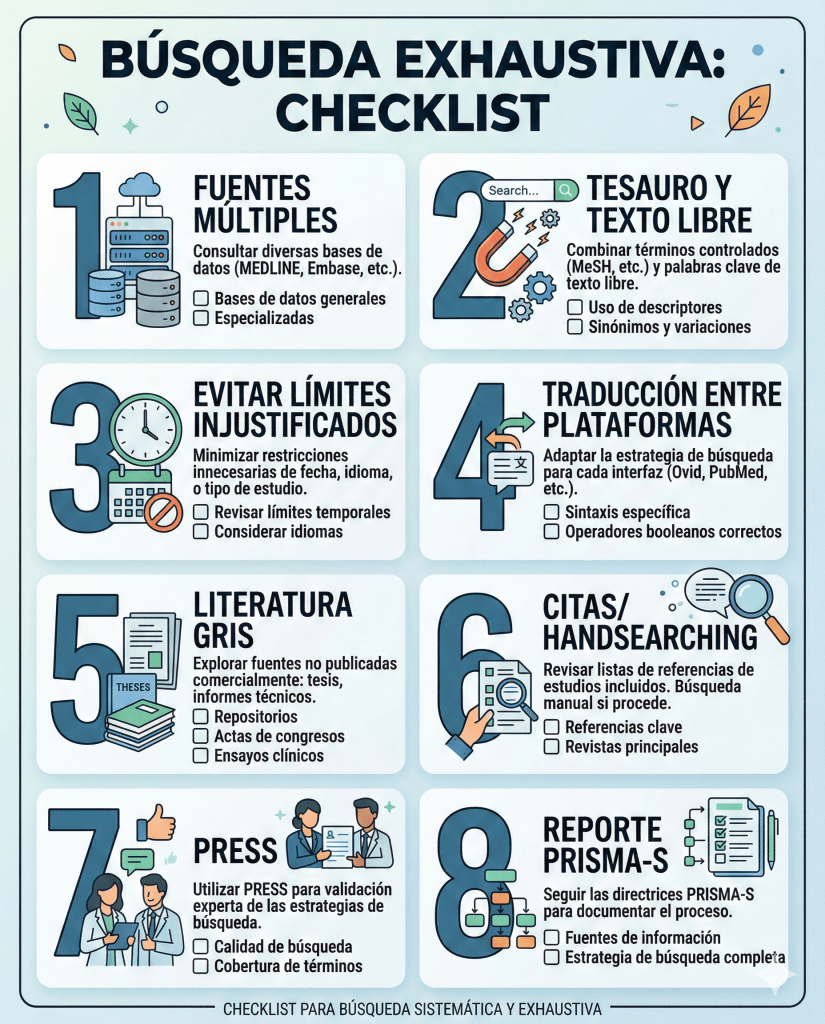

¿Cuáles son los componentes de una búsqueda exhaustiva?

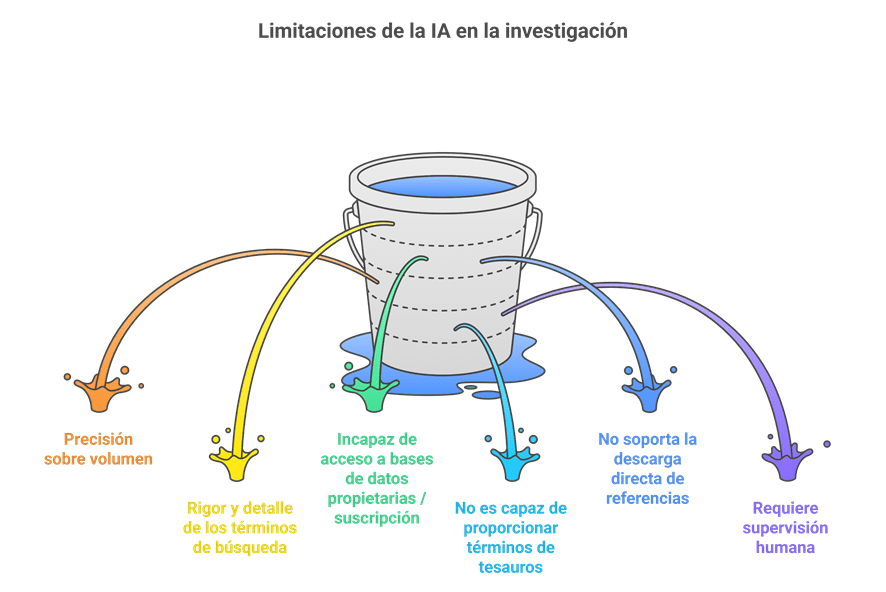

A. Múltiples bases y fuentes

Una búsqueda exhaustiva combina:

- Bases bibliográficas generales y especializadas (según tema). Se recomienda realizar búsquedas en un rango de 3 a 5 bases de datos bibliográficas académicas relevantes para el área de estudio (por ejemplo, MEDLINE, EMBASE, CINAHL o Scopus).

- Registros de ensayos y repositorios de resultados cuando aplica (p. ej., ClinicalTrials.gov, ICTRP).

- Literatura gris. Incluye investigaciones que no han sido publicadas en revistas comerciales tradicionales (como tesis, informes técnicos o actas de conferencias). Omitir la literatura gris puede introducir un sesgo significativo, ya que a menudo los estudios con resultados negativos o neutrales no llegan a publicarse en revistas de alto impacto (sesgo de reporte).

- Búsqueda web (agencias reguladoras, organizaciones, etc.).

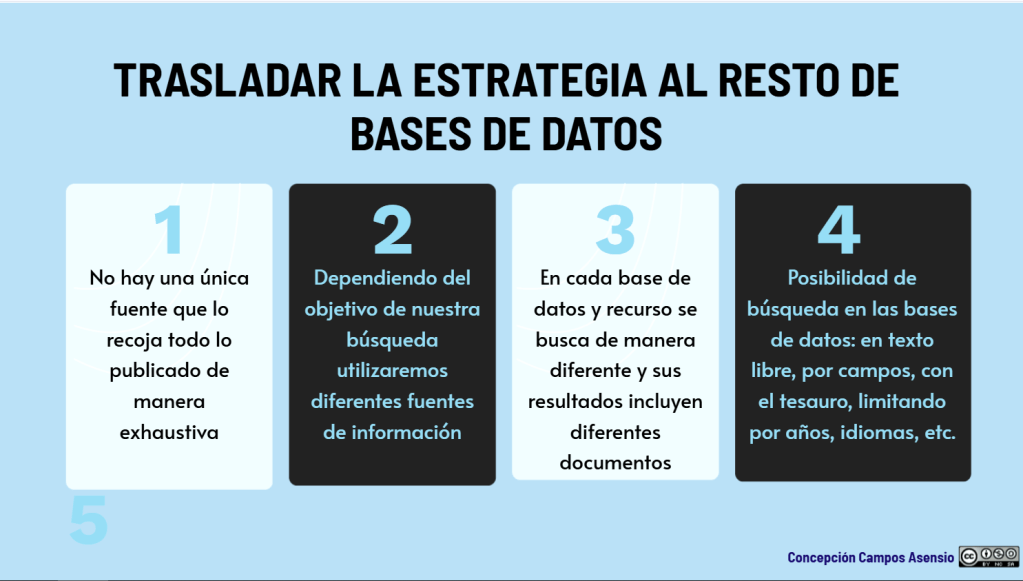

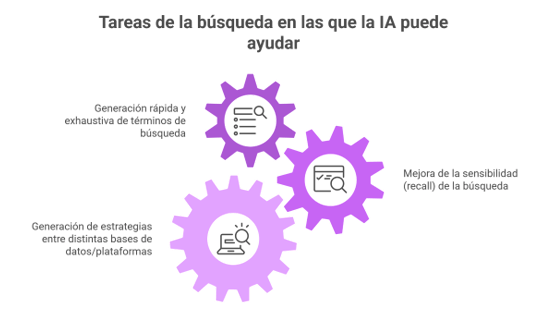

B. Vocabulario controlado + texto libre (y traducción entre plataformas)

Hay que usar tanto texto libre como encabezamientos (MeSH, Emtree, etc.) y personalizar y adaptar las estrategias por cada base.

Además, recuerda que MeSH≠Emtree, la indización difiere y para ser lo más exhaustivo posible hay que incorporar un rango amplio de sinónimos, variantes ortográficas, truncamientos y operadores de proximidad.

Siempre recordando que “traducir la estrategia” no es copiar/pegar; es conservar el concepto y adaptar la sintaxis y el comportamiento del buscador (campos, explosión, proximidad, stopwords, mapeo automático).

C. Técnicas adicionales

La propia lógica metodológica es simple: ninguna base indexa “todo” y la evidencia muestra que métodos suplementarios pueden añadir estudios que el searching en bases no recupera. Para cerrar el círculo de la exhaustividad, se deben emplear métodos como la «búsqueda manual» (handsearching) y el «encadenamiento de citas» (citation chaining), que consiste en revisar las referencias de los artículos encontrados para localizar estudios adicionales que las bases de datos pudieron omitir.

D. Control de calidad: revisión por pares de la estrategia (PRESS)

El estándar PRESS (6) formaliza la revisión por pares de estrategias electrónicas y define elementos típicos donde aparecen errores (operadores booleanos/proximidad, encabezamientos, texto libre, límites/filtros, sintaxis, etc.). PRISMA 2020 incluso sugiere reportar si hubo peer review y qué herramienta se utilizó (p. ej., PRESS).

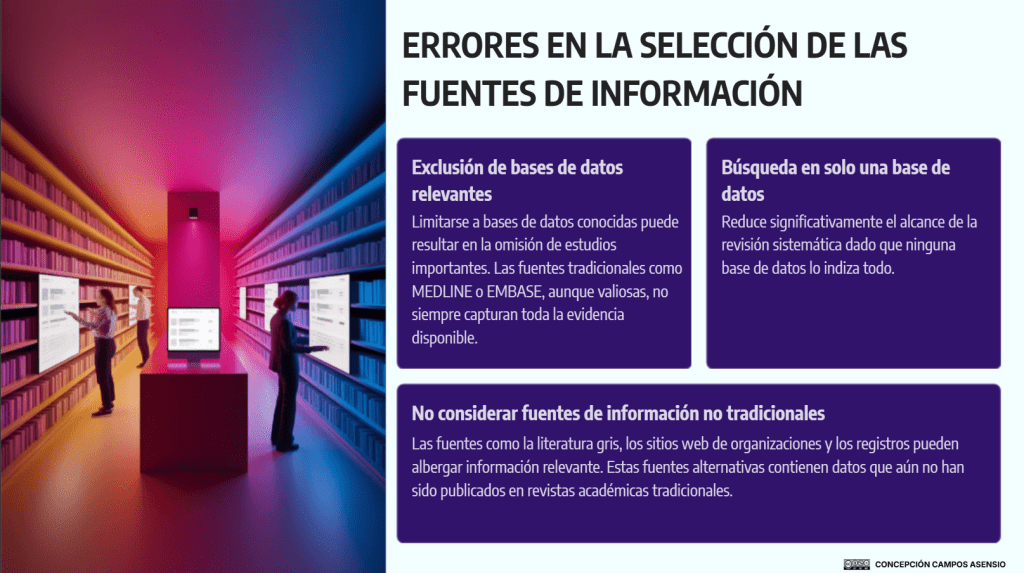

Errores frecuentes que “rompen” la exhaustividad

- Una sola base (o varias, pero sin complementariedad).

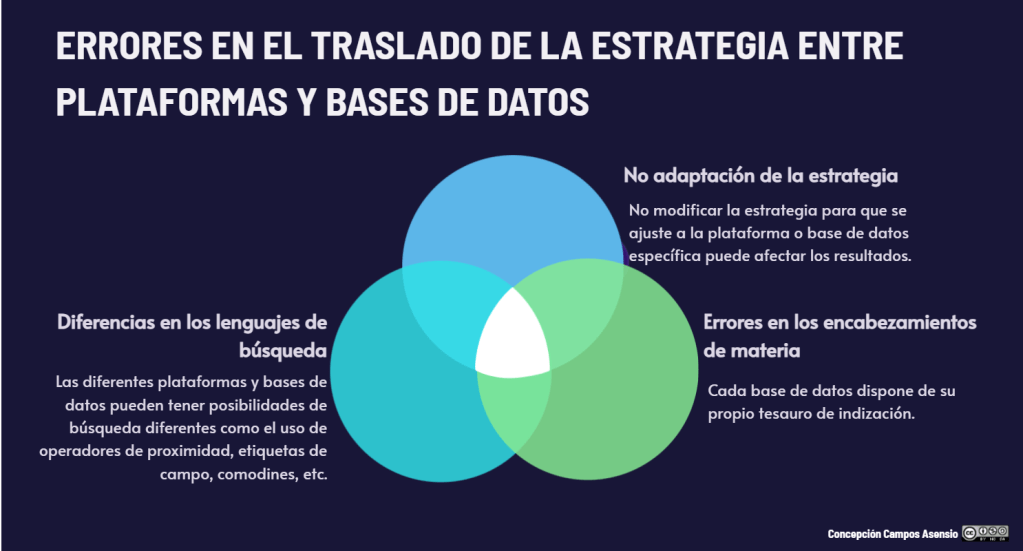

- No combinar tesauro + texto libre, o no adaptar la estrategia a cada base.

- Límites no justificados (idioma/fecha/tipo de documento) aplicados en la búsqueda, no como criterio de selección. PRISMA pide que los límites se reporten y se justifiquen en relación con criterios de elegibilidad.

- Omitir literatura gris/registros cuando el riesgo de sesgo de publicación es material.

- No informar de las estrategias completas (solo “buscamos en PubMed y Embase”): impide evaluar calidad, reproducir y actualizar.

BIBLIOGRAFÍA

- Lefebvre C, Glanville J, Briscoe S, Featherstone R, Littlewood A, Metzendorf M-I, Noel-Storr A, Paynter R, Rader T, Thomas J, Wieland LS. Chapter 4: Searching for and selecting studies [last updated March 2025]. En: Higgins JP, Thomas J, Chandler J, Cumpston M, Li T, Page MJ, et al, editor(s). Cochrane Handbook for Systematic Reviews of Interventions version 6.5.1 Cochrane, 2025.Disponible en: cochrane.org/handbook.

- Ewald H., Klerings I., Wagner G., Heise TL., Stratil JM., Lhachimi SK., et al. Searching two or more databases decreased the risk of missing relevant studies: a metaresearch study. Journal of Clinical Epidemiology. 2022;149:154-64, doi: 10.1016/j.jclinepi.2022.05.022.

- Bramer WM, Rethlefsen ML, Kleijnen J, Franco OH. Optimal database combinations for literature searches in systematic reviews: a prospective exploratory study. Syst Rev. 2017 Dec 6;6(1):245. doi: 10.1186/s13643-017-0644-y.

- Page MJ, Moher D, Bossuyt PM, Boutron I, Hoffmann TC, Mulrow CD, Shamseer L, Tetzlaff JM, Akl EA, Brennan SE, Chou R, Glanville J, Grimshaw JM, Hróbjartsson A, Lalu MM, Li T, Loder EW, Mayo-Wilson E, McDonald S, McGuinness LA, Stewart LA, Thomas J, Tricco AC, Welch VA, Whiting P, McKenzie JE. PRISMA 2020 explanation and elaboration: updated guidance and exemplars for reporting systematic reviews. BMJ. 2021 Mar 29;372:n160. doi: 10.1136/bmj.n160.

- Rethlefsen ML, Kirtley S, Waffenschmidt S, Ayala AP, Moher D, Page MJ, Koffel JB; PRISMA-S Group. PRISMA-S: an extension to the PRISMA Statement for Reporting Literature Searches in Systematic Reviews. Syst Rev. 2021 Jan 26;10(1):39. doi: 10.1186/s13643-020-01542-z.

- McGowan J, Sampson M, Salzwedel DM, Cogo E, Foerster V, Lefebvre C. PRESS Peer Review of Electronic Search Strategies: 2015 Guideline Statement. J Clin Epidemiol. 2016 Jul;75:40-6. doi: 10.1016/j.jclinepi.2016.01.021.