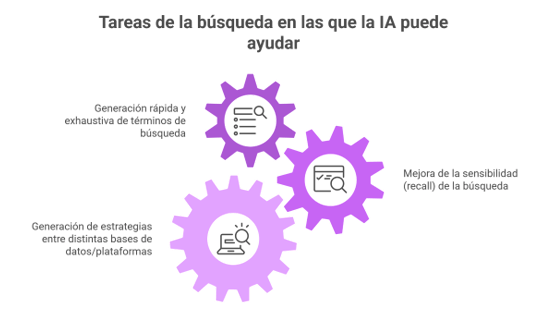

Imagina esto: después de meses de analizar y organizar datos, ya tienes lista tu revisión sistemática para enviarla. Pero, justo días antes de enviarla, te topas por casualidad con tres artículos clave que tu estrategia de búsqueda ni siquiera consideró y que cambian todo lo que pensabas. Es el miedo más grande de cualquier bibliotecario: no saber si realmente has encontrado todo lo que hay.

Y es que cuando trabajamos en síntesis de evidencia, la «intuición» del experto o la simple acumulación de años de experiencia no son salvaguardas suficientes. Y por eso es tan necesario la validación de la sensibilidad de la búsqueda de evidencia que transforma una recopilación bibliográfica convencional en un proceso científico reproducible y defendible ante cualquier auditoría metodológica.

Este interesante artículo de Lagisz et al, recientemente publicado, nos da unas pautas de actuación para evaluar la sensibilidad de las estrategias de búsqueda. Analicemos este artículo y su propuesta.

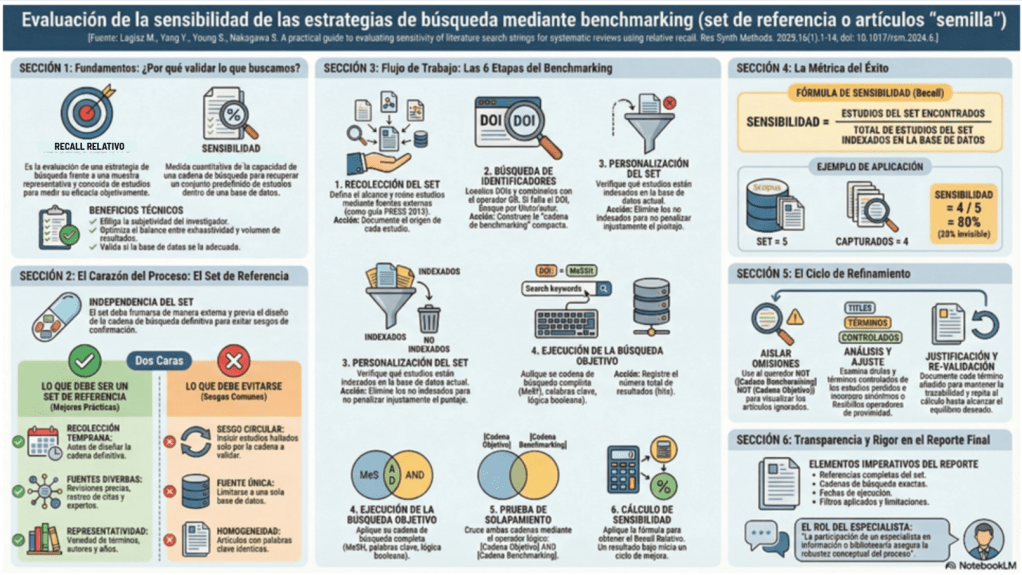

«Recall absoluto» y «recall relativo»

En revisiones sistemáticas se prioriza típicamente «alto «recall» (minimizar pérdida de estudios relevantes), aceptando un descenso de precisión que luego se gestiona con cribado. En el ámbito de la recuperación de información, es teóricamente imposible garantizar un «recall absoluto». Esto se debe a que el universo total de la literatura existente es, por definición, desconocido; no podemos medir lo que no sabemos que existe. Para resolver esta incertidumbre, debemos adoptar el concepto pragmático de «recall relativo« (o sensibilidad).

Bajo este enfoque, evaluamos nuestra estrategia frente a una muestra representativa y conocida de estudios. Esto nos permite sustituir la subjetividad por una métrica objetiva de rendimiento, optimizando el balance entre la exhaustividad y la manejabilidad de los resultados.

El corazón del proceso es el set de referencia o artículos «semilla«. Un error metodológico crítico es el sesgo circular: diseñar la estrategia de búsqueda y luego seleccionar para el set de validación artículos que esa misma cadena ya encontró. Esto no es más que un sesgo de Confirmación que «engaña» al cálculo con artículos homogéneos, invalidando la prueba de estrés de la estrategia.

Para que este set actúe como un verdadero «estándar de oro», debe ser externo y recolectado mediante mejores prácticas:

• Recolección Temprana: El set debe reunirse estrictamente antes de diseñar la estrategia de búsqueda definitiva.

• Fuentes Diversas: Debe incluir revisiones sistemáticas previas, rastreo de citas (backward/forward tracking), etc.

• Revisión por Expertos: Consulta con especialistas en el área temática para garantizar la representatividad de autores y años.

• Heterogeneidad: Debe reflejar la variedad de terminología y términos controlados del tema para evitar la homogeneidad simplista.

6 Etapas del flujo de trabajo del bibliotecario

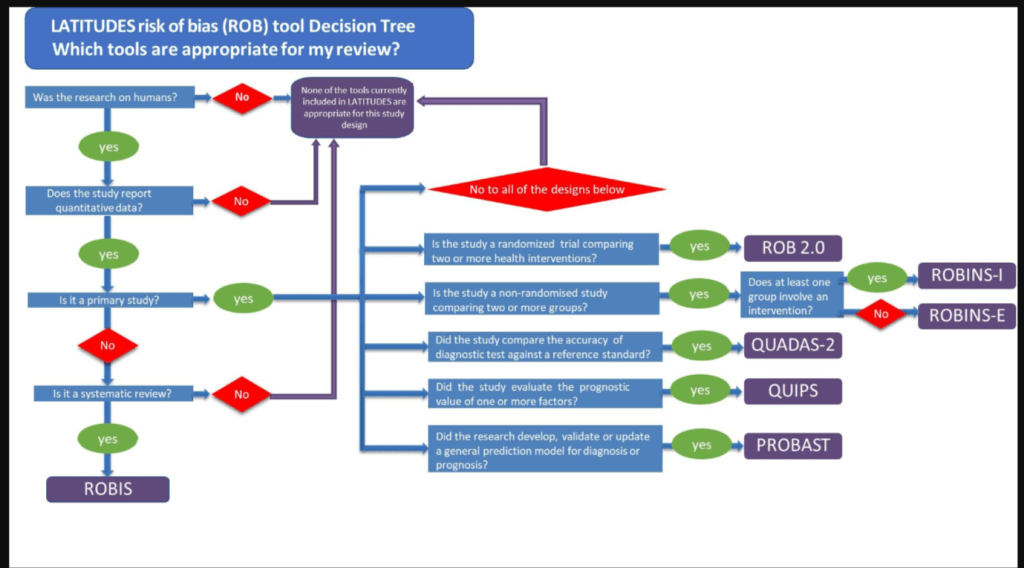

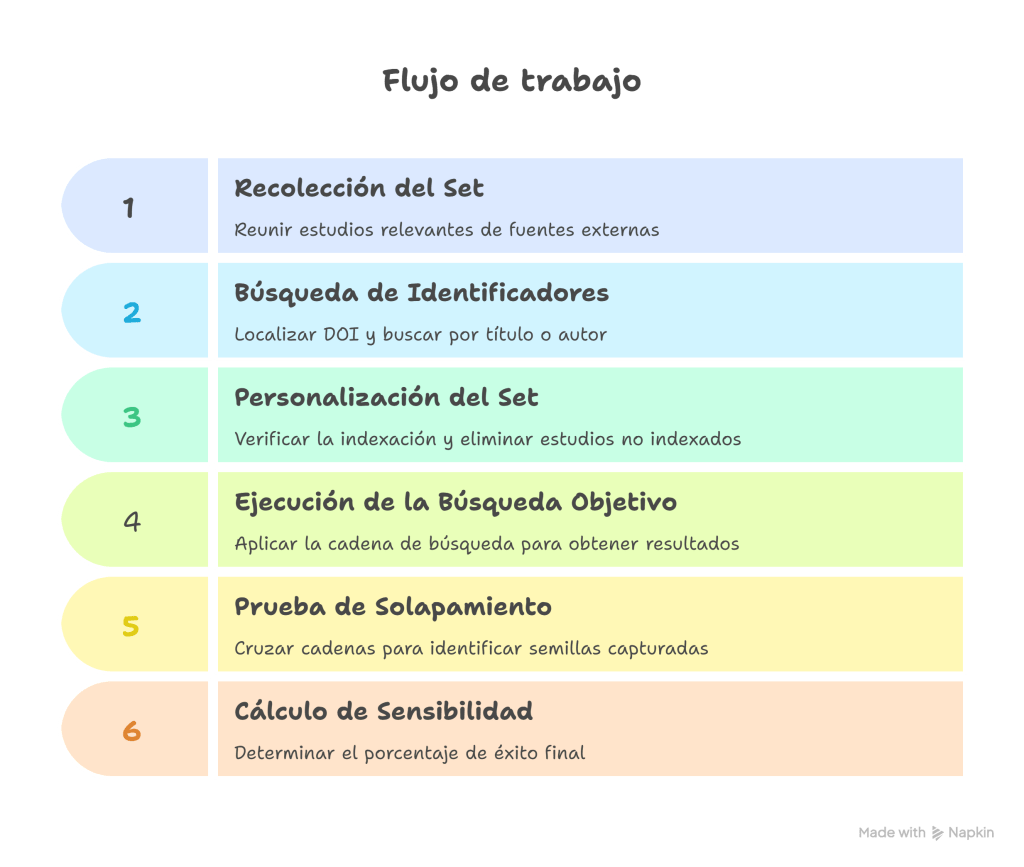

Para validar nuestra búsqueda, Lagisz et al., nos sugieren seguir este flujo de trabajo secuencial:

- Recolección del set de evaluación comparativa («benchmarking»): Define el alcance y reúne los estudios que sean útiles que encuentres, ya sea hablando con expertos o buscando en otras fuentes.

- Búsqueda de identificadores: Localiza los DOI de cada estudio y combínalos con el operador

ORpara crear una «cadena de benchmarking» compacta. Si un estudio no aparece por DOI, debe buscarse por título o autor para verificar si la ausencia es real. - Personalización del set: Verifica cuáles estudios están indexados en la base de datos actual. Debemos eliminar los estudios no indexados del cálculo para no penalizar injustamente el puntaje de sensibilidad (unfairly lowering the sensitivity score).

- Ejecución de la búsqueda objetivo: Aplica tú estrategia de búsqueda completa (MeSH, Emtree, palabras clave y lógica booleana) y registra el número total de resultados (hits).

- Prueba de solapamiento: Cruza ambas cadenas mediante el operador

ANDen un bloque lógico simple:[Cadena de Búsqueda Objetivo] AND [Cadena del set de evaluación comparativa]. - Cálculo de sensibilidad: Aplica la fórmula para obtener el «recall relativo» y determina si el resultado inicia un ciclo de mejora.

Cálculo e Interpretación

En una revisión sistemática, buscamos una sensibilidad alta, pero esto suele aumentar el «ruido» (resultados irrelevantes). No existe un umbral universal del 100% por lo que el equipo de revisión debe decidir cuándo la búsqueda es «suficientemente buena».

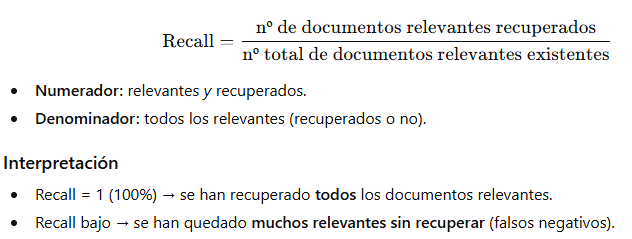

Fórmula de sensibilidad (recall):

Sensibilidad = (Estudios del set encontrados) / (Total de estudios del set indexados en la base de datos)

Ejemplo práctico: Si su set de referencia consta de 5 artículos indexados en Scopus y su cadena objetivo captura 4 de ellos:

Cálculo: 4 / 5 = 0.8

Resultado: 80% de sensibilidad.

Interpretación: El 20% de la literatura clave es «invisible« para su búsqueda actual, lo que exige una justificación técnica de si ese nivel de riesgo es aceptable o requiere refinamiento.

¿Qué pasa si la sensibilidad es baja?

Si este es nuestro caso, debemos realizar un análisis diagnóstico de los estudios «no capturados» siguiendo esta lista de tareas para el Refinamiento:

- Aislar omisiones: Ejecutar Cadena de Benchmarking NOT Cadena de Búsqueda Objetivo para visualizar exclusivamente los artículos que su estrategia ignoró.

- Análisis de registros: Examinar los campos de título, resumen y términos controlados (encabezamientos de materia) de los estudios perdidos.

- Ajuste de lógica: Incorporar sinónimos detectados o flexibilice los operadores de proximidad y truncamiento.

- Justificación Técnica: Documentar la justificación razonada detrás de cada término añadido para mantener la trazabilidad.

- Revalidación: Repetir el cálculo de sensibilidad hasta alcanzar el equilibrio deseado por el equipo de revisión. Este refinamiento garantiza que la búsqueda final sea un reflejo fiel del estado del arte, cumpliendo con los estándares de transparencia internacional.

Bibliografía

Lagisz M, Yang Y, Young S, Nakagawa S. A practical guide to evaluating sensitivity of literature search strings for systematic reviews using relative recall. Res Synth Methods. 2025 Jan;16(1):1-14. doi: 10.1017/rsm.2024.6.